- Today

- Total

hye-log

[부스트캠프 AI Tech]WEEK 03_DAY 12 본문

🌱 개별학습

[3] Optimization

1. Important Concepts in Optimization

1) Generalization(일반화)

- Generalization gap(training error와 test error 사이의 차)를 줄이는 것이 목적

- 학습을 통해 training error가 줄어 0이 되어도 test error가 커질 수 있기 때문에 일반화 성능을 높이는 것이 중요

2) Underfitting vs. Overfitting

- Overfitting(과적합)은 training error보다 test error가 커서 training data에 지나치게 fitting 된 상태

- Underfitting과 Overfitting 사이의 balanced 모델을 만드는 것이 중요

3) Cross-Validation

- traing data를 train, valid, test로 나누어서 사용

- valid는 train의 학습이 얼마나 잘 되었는지 판단하기 위해 사용

4) Bias and Variance

- Bias : 얼마나 mean(평균)에 가까운지

- Variance : 얼마나 일관적인지

5) Bootstrapping

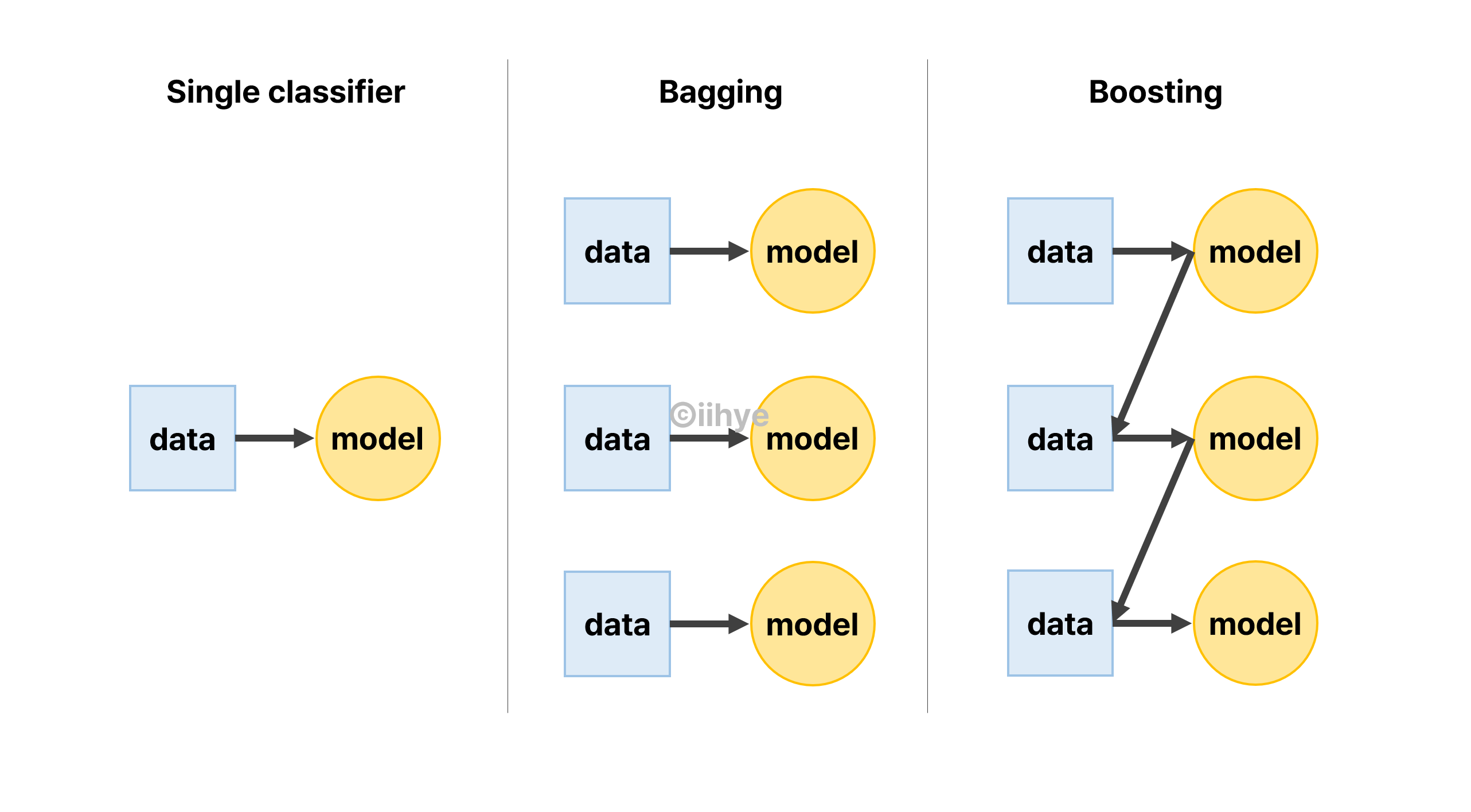

- Bagging(Boostrapping aggregating) : 데이터를 샘플링한 후 개별 모델 학습

- Boosting : 분류하기 어려운 샘플에 가중치를 두어 학습함

2. Practical Gradient Descent Methods

1) Gradient Descenet Methods

- Stochastic Gradient Descent(SGD) : 단일 샘플로부터 계산한 gradient로 업데이트

- Mini-batch Gradient Descent : 일부 데이터로부터 계산한 gradient로 업데이트

- Batch Gradient Descent : 전체 데이터로부터 계산한 gradient로 업데이트

2) Batch-size Matters

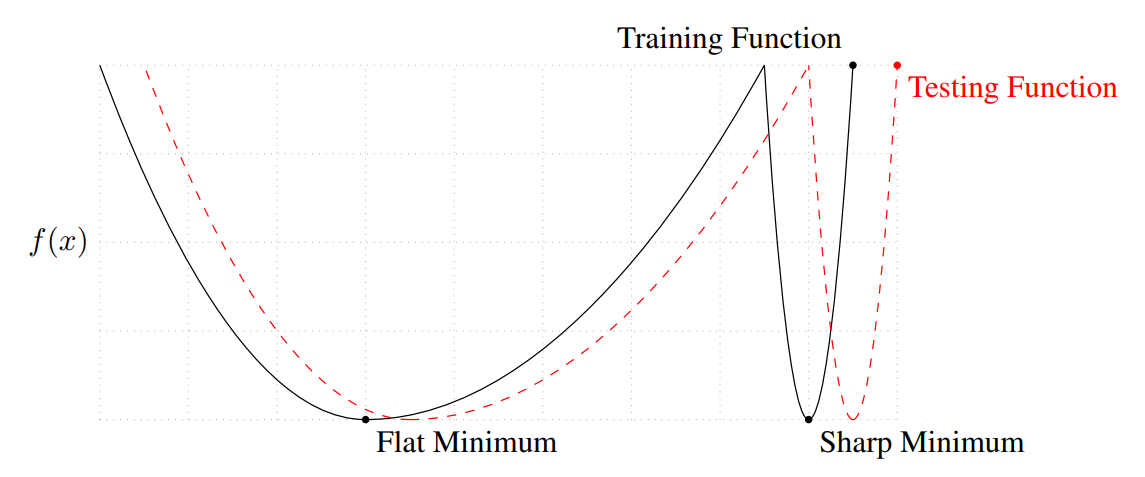

- Small batch-size는 Flat Minimum을 가져옴

- Large batch-size는 Sharp Minimum을 가져옴

- training function에서 잘 동작하면 testing fuction에서도 잘 되는 것이 generalization

3) Gradient Descent

- learning rate(η) 잡기가 어렵다는 단점이 있음

4) Momentum

- momentum(β)가 포함된 gradient 사용

- momentum은 한 번 흐른 방향을 어느 정도 유지시켜줘서 학습에 유리함

5) Nesterov Accelerated Gradient

- Lookahead gradient를 사용

6) Adagrad

- 지금까지의 gradient가 얼마나 변했는지(sum of gradient squares)를 사용

- G가 계속 커지면 학습이 멈추는 현상 발생

7) Adadelta

- learning rate 없이 계속 커지는 G를 막기 위해서 고안

8) RMSprop

- step 사이즈를 이용하여 gradient 계산

9) Adam

- 적절한 learning rate를 사용

- 이전 gradient 정보인 momentum을 이용

3. Regularization

1) Early Stopping : generalization gap이 증가하지 않는 구간에서 학습을 종료함

2) Parameter Norm Penalty : parameter가 커지지 않게 모델 복잡도를 낮추는 방법

3) Data Augmentation : 데이터를 가공하여 모델의 성능을 향상시키는 방법

- label이 변하지 않는 선에서 데이터를 가공

- 예) MNIST에서 flip, rotate 등 augmentation 기법은 사용하지 않아야 함

4) Noise Robustness : input이나 weight에 noise를 부여하여 강인한 모델을 만드는 방법

5) Label Smoothing : 데이터를 뽑아서 섞는 방법

6) Dropout : 일부 노드의 가중치를 0으로 만드는 방법

7) Batch Normalization

🌱 오늘의 회고

기본 과제를 해결하고 optimizer 강의를 들었다! 강의 내용이 그렇게 긴 건 아닌데 생각보다 강의 듣고 이해하는데 시간이 오래 걸린 편... 처음 배우는 내용은 아니지만 다시 들을수록 '아!' 하는 내용도 있고, '아?'하는 내용들도 있다(머쓱) 내일은 CNN, RNN 까지 듣고 과제 마치는 것이 목표..! 피어세션 때 데이콘에서 대회 하나 정해서 나가보자는 의견이 있었다. 월간 데이콘 대회를 찾아보니 그림의 일부를 보고 화가를 맞추는 문제인데 우선 화가가 50명 있고, 그렇다면 classification을 50개 해야하는건가..ㅇㅅㅇ 데이터를 보니 이걸 할 수 있을지 걱정도 되지만, 경진대회 하면서 실력 느는게 크니까 뭐든 열심히 해보자😊

(+) 오늘 뭔가 느낌이 와서 메일함 계속 열어봤는데 서류합 메일이 왔다! 열흘 간 코테 열심히 파이링✨

'Boostcourse > AI Tech 4기' 카테고리의 다른 글

| [부스트캠프 AI Tech]WEEK 03_DAY 14 (0) | 2022.10.11 |

|---|---|

| [부스트캠프 AI Tech]WEEK 03_DAY 13 (0) | 2022.10.07 |

| [부스트캠프 AI Tech]WEEK 03_DAY 11 (0) | 2022.10.05 |

| [부스트캠프 AI Tech]WEEK 02_DAY 10 (1) | 2022.09.30 |

| [부스트캠프 AI Tech]WEEK 02_DAY 09 (0) | 2022.09.29 |