- Today

- Total

hye-log

[부스트캠프 AI Tech]WEEK 02_DAY 08 본문

🎀 개별학습

[6] 모델 불러오기

1. model.save()

1) 학습의 결과를 저장하기 위한 함수

2) 모델의 형태와 parameter를 저장

# Print model's state_dict

# state_dict: 모델의 parameter를 표시

for param_tensor in model.state_dict():

print(param_tensor, "\t", model.state_dict()[param_tensor].size())

# 모델의 parameter를 저장

torch.save(model.state_dict(), os.path.join(MODEL_PATH, "model.pt"))

# 같은 모델의 형태에서 parameter만 load

new_model = TheModelClass()

new_model.load_state_dict(torch.load(os.path.join(MODEL_PATH, "model.pt")))

# 모델의 architecture와 함께 저장

torch.save(model, os.path.join(MODEL_PATH, "model.pt"))

# 모델의 architecture와 함께 load

model = torch.load(os.path.join(MODEL_PATH, "model.pt"))

2. checkpoints

1) 학습의 중간 결과를 저장하여 최선의 결과를 선택

2) earlystopping 기법 사용 시 이전 학습의 결과물을 저장

3) epoch, loss, metric을 함께 저장하여 확인

# checkpoint

# 모델의 정보를 epoch와 함께 저장

torch.save({'epoch': e,

'model_state_dict': model.state_dict(),

'optimizer_state_dict': optimizer.state_dict(),

'loss': epoch_loss,},

f'saved/checkpoint_model_{e}_{epoch_loss/len(dataloader}_{epoch_acc/len(dataloader)}.pt')

# load checkpoint

checkpoint = torch.load(PATH)

# load model of checkpoint

model.load_state_dict(checkpoint['model_state_dict'])

# load optimizer of checkpoint

optimizer.load_state_dict(checkpoint['optimizer_state_dict'])

# load epoch of checkpoint

epoch = checkpoint['epoch']

# load loss of checkpoint

loss = checkpoint['loss']

3. Transfer Learning

1) 다른 데이터셋으로 만든 모델을 현재 데이터에 적용

2) 일반적으로 대용량 데이터셋으로 만들어진 모델의 성능이 더 좋음

3) Deep Learning에서 일반적인 학습 기법

4) TorchVision에서 다양한 기본 모델 제공

- 참고 : https://pytorch.org/vision/0.8/models.html

torchvision.models — Torchvision 0.8.1 documentation

torchvision.models The models subpackage contains definitions of models for addressing different tasks, including: image classification, pixelwise semantic segmentation, object detection, instance segmentation, person keypoint detection and video classific

pytorch.org

5) freezing : pretrained model을 활용시 모델의 일부분을 frozen 시킴

# transfer learning

# vgg16 모델을 vgg에 할당

vgg = models.vgg16(pretrained=True).to(device)

class MyNewNet(nn.Module):

def __init__(self):

super(MyNewNet, self).__init__()

self.vgg19 = models.vgg19(pretrained=True)

# 모델의 마지막에 linear_layer 추가

self.linear_layers = nn.Linear(1000, 1)

# Defining the forward pass

def forward(self, x):

x = self.vgg19(x)

return self.linear_layers(x)

# 마지막 레이어를 제외하고 frozen

for param in my_model.parameters():

param.requires_grad = False

for param in my_model.linear_layers.parameters():

param.requires_grad = True[7] Monitoring tools for PyTorch

1. Tensorboard

1) TensorFlow의 프로젝트로 만들어진 시각화 도구

2) 학습 그래프, metric, 학습 결과의 시각화 지원

3) PyTorch 연결 가능

4) 종류

- scalar : metric 등 상수 값의 연속을 표시

- graph : 모델의 computational graph 표시

- histogram : weight 등 값의 분포를 표현

- image : 예측 값과 실제 값의 비교를 표시

- mesh : 3d 형태의 데이터를 표현

# Tensorboard

import os

logs_base_dir = "logs"

# Tensorboard 기록을 위한 directory 생성

os.makedirs(logs_base_dir, exist_ok=True)

from torch.utils.tensorboard import SummaryWriter

import numpy as np

# 기록 생성 객체 SummaryWriter 생성

exp = f"{logs_base_dir}/ex3"

writer = SummaryWriter(exp)

for n_iter in range(100):

# add_scalar : scalar 값을 기록

writer.add_scalar('Loss/train', np.random.random(), n_iter)

writer.add_scalar('Loss/test', np.random.random(), n_iter)

writer.add_scalar('Accuracy/train', np.random.random(), n_iter)

writer.add_scalar('Accuracy/test', np.random.random(), n_iter)

# 값 기록(disk에 쓰기)

writer.flush()

# tensorboard 수행

%load_ext tensorboard

%tensorboard --logdir "logs"

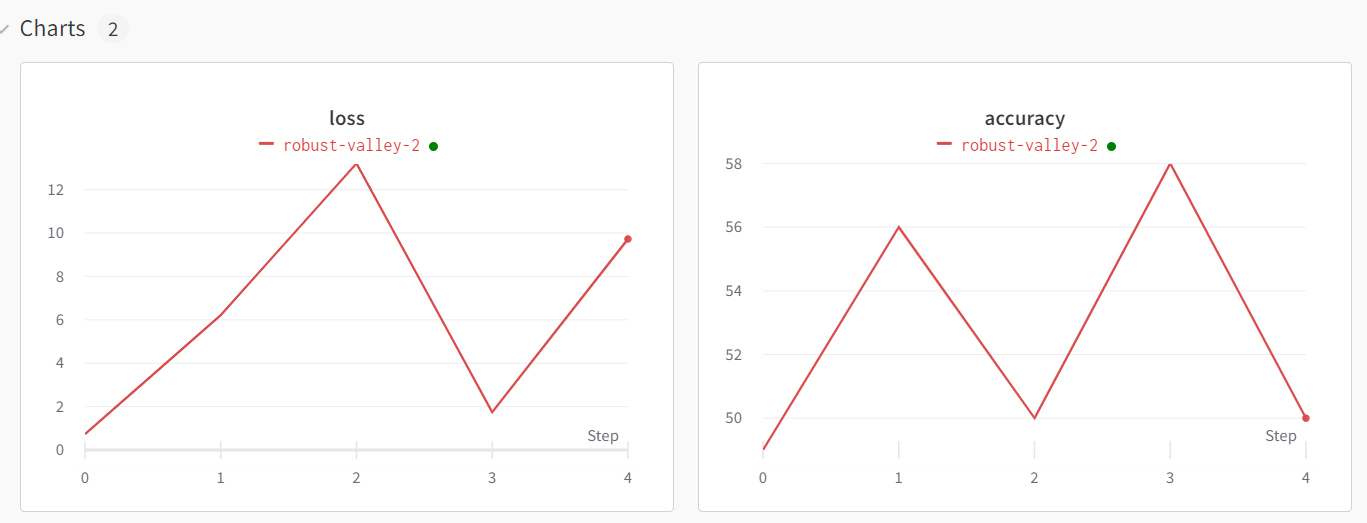

2. Weights&Biases

1) 머신러닝 실험을 원활히 지원하기 위한 상용도구

2) 협업, code versioning, 실험 결과 기록 등 제공

# wandb

!pip install wandb-q

# config 설정

config={'epochs':EPOCHS, 'batch_size':BATCH_SIZE, 'learning_rate':LEARNING_RATE}

wandb.init(project='my-test-project', config=config)

for e in range(1, EPOCHS+1):

epoch_loss = 0

epoch_acc = 0

for x_batch, y_batch in train_dataset:

x_batch, y_batch = x_batch.to(device), y_batch.to(device).type(torch.cuda.FloatTensor)

#...

optimizer.step()

#...

# wandb에 기록

wandb.log({'accuracy': train_acc, 'loss': train_loss})

🎀 오늘의 회고

오전에는 강의 파이토치 강의 6강을 듣고, 오후에는 7강과 기본 2 과제를 풀어보았다. 확실히 부덕이가 나오지 않는 기본 1 과제보다 양은 적어보였으나 어렵다.. 데이터를 불러오고 데이터셋을 만들고 코드로 하나씩 작성해보니 이해가 가는거 같기도 하고 아직도 잘 모르겠다ㅠㅠ 피어세션 때는 과제 관련된 이야기만 한거 같다. 벌써 수요일, 이번 주는 과제 마감이 빨라서 내일까지 기본 1, 2 과제 다시 점검하고 제출하는 게 목표이다. 오늘 두런두런 1회차에서는 변성윤 마스터께서 마스터님의 삶에 대해서 소개해주셨다. 실패와 성공이 반복된 인생이었는데, 지금 우리가 보기에는 성공한 인생으로 보이지만, 마스터님도 수도 없는 실패를 겪어오면서 단단해지신거 같아서 부러웠다..!! 나도 언젠가 마스터님처럼 단단한 사람이 될 수 있겠지..

'Boostcourse > AI Tech 4기' 카테고리의 다른 글

| [부스트캠프 AI Tech]WEEK 02_DAY 10 (1) | 2022.09.30 |

|---|---|

| [부스트캠프 AI Tech]WEEK 02_DAY 09 (0) | 2022.09.29 |

| [부스트캠프 AI Tech]WEEK 02_DAY 07 (0) | 2022.09.27 |

| [부스트캠프 AI Tech]WEEK 02_DAY 06 (1) | 2022.09.26 |

| [부스트캠프 AI Tech]WEEK 01_DAY 05 (1) | 2022.09.23 |